L’Intelligence Artificielle utilisée dans ChatGPT, Midjourney, Google Gemini ou Mistral ne “pense” pas comme un humain. Elle reconnaît des modèles dans d’immenses quantités de données et prédit la suite logique d’un texte, d’une image ou d’un son. Pour exploiter pleinement ces outils dans vos études et vos futurs métiers, il est essentiel de comprendre les grandes briques technologiques : le Machine Learning, le Deep Learning, les modèles de langage (LLM) et le Prompt Engineering.

Ce cours magistral vous offre une vision claire des mécanismes internes de l’IA tout en montrant des applications directes dans votre quotidien (prospection, relation client, analyse CRM, marketing, etc.).

L’objectif est simple : comprendre comment les machines apprennent, comment elles analysent et génèrent du langage, et comment vous pouvez les piloter efficacement grâce à un bon prompt.

Version podcast de cet article :

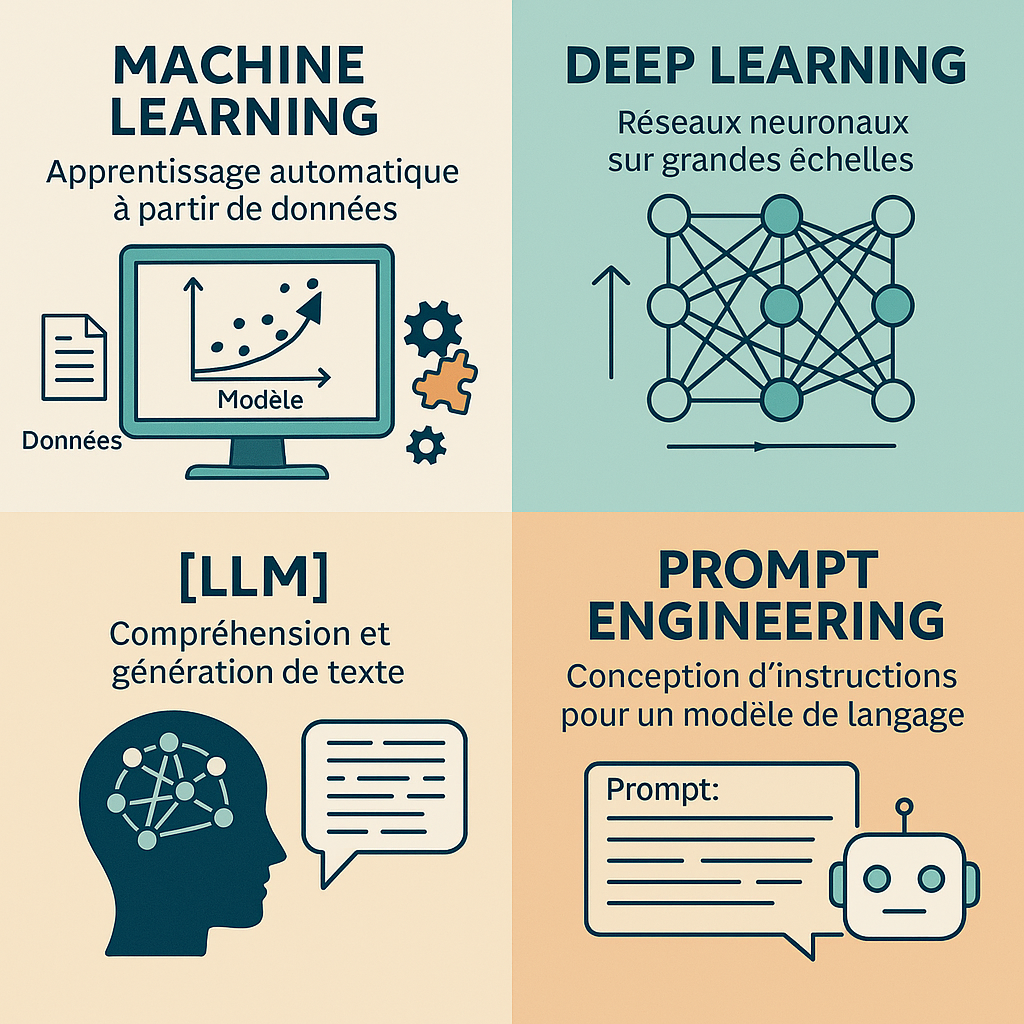

1. Machine Learning : la base de l’intelligence artificielle moderne

1.1. Définition simple

Le Machine Learning repose sur une idée simple : au lieu de programmer explicitement chaque règle, on fournit au modèle de nombreux exemples et il apprend à reconnaître des patterns (schémas).

- données d’entrée : emails, fiches clients, historiques de ventes ;

- étiquettes éventuelles : “spam / pas spam”, “achat / non-achat”.

Le modèle ajuste ses paramètres internes jusqu’à produire des prédictions correctes. Une fois entraîné, il sait généraliser sur de nouvelles données.

1.2. Les trois grandes familles du Machine Learning

1.2.1. Apprentissage supervisé

L’apprentissage supervisé utilise des données annotées. Chaque exemple est associé à la “bonne réponse”. Le modèle apprend à associer des entrées (caractéristiques) à des sorties (résultats attendus).

Exemples NDRC :

- Prédiction de conversion d’un prospect (étiquette : “converti / non converti”).

- Évaluation du churn (risque de perte client) à partir des historiques d’achats et d’utilisation.

- Classification automatique de messages SAV (réclamation, question produit, problème de livraison…).

1.2.2. Apprentissage non supervisé

L’apprentissage non supervisé ne reçoit aucune étiquette. Le modèle détecte seul des regroupements naturels dans les données.

- Segmentation automatique de clients en groupes de comportements proches.

- Détection d’anomalies (clients qui ont un comportement très différent de la moyenne).

- Clustering de produits pour proposer du cross-selling (produits souvent achetés ensemble).

1.2.3. Apprentissage par renforcement

L’apprentissage par renforcement fonctionne comme un jeu : un agent teste des actions, reçoit des récompenses ou des pénalités, puis ajuste sa stratégie pour maximiser la récompense totale.

- Optimisation de campagnes publicitaires (tester différentes enchères, créas, audiences et conserver ce qui fonctionne le mieux).

- Optimisation de workflows utilisateurs sur un site (maximiser les conversions en étudiant les parcours).

- Agents intelligents dans les jeux vidéo qui apprennent à gagner sans que toutes les règles soient codées à la main.

2. Deep Learning : la puissance des réseaux neuronaux

2.1. Qu’est-ce qu’un réseau neuronal ?

Un réseau neuronal est un modèle constitué de nombreuses couches de “neurones artificiels” connectés entre eux. Chaque neurone reçoit des nombres, effectue un calcul simple, puis transmet un résultat à la couche suivante.

On peut voir cela comme une chaîne de filtres :

- les premières couches détectent des signaux simples (contours, couleurs, mots fréquents) ;

- les couches suivantes repèrent des motifs plus complexes (formes, phrases typiques) ;

- les couches finales reconnaissent des concepts abstraits (objet, intention, sujet d’un texte).

2.2. Pourquoi parle-t-on de “Deep” Learning ?

On parle de Deep Learning lorsque le réseau possède de nombreuses couches. Plus il est “profond”, plus il peut apprendre des représentations sophistiquées, à condition de disposer de :

- beaucoup de données ;

- beaucoup de puissance de calcul ;

- des algorithmes d’optimisation efficaces.

2.3. Exemples de Deep Learning dans votre quotidien

- Reconnaissance faciale pour déverrouiller un smartphone.

- Recommandations personnalisées sur Netflix, Spotify, YouTube, Amazon.

- Assistants vocaux (Siri, Google Assistant, Alexa) qui transforment la voix en texte et en actions.

- Filtres de spam dans les boîtes mail.

- Voitures autonomes qui analysent en temps réel l’environnement visuel et prennent des décisions.

3. Les LLM (Large Language Models) : quand les réseaux neuronaux apprennent le langage

Les LLM (Large Language Models) sont des réseaux neuronaux spécialisés dans le traitement et la génération de langage naturel. Ils sont entraînés sur des milliards de mots provenant de livres, d’articles, de sites web, etc., afin d’apprendre à prédire la suite la plus probable d’une séquence de texte.

3.1. Les tokens : découper le langage en morceaux

Les LLM ne travaillent pas directement avec des phrases complètes. Ils convertissent d’abord le texte en tokens : des unités plus petites (mots, sous-mots ou symboles).

Par exemple, un mot comme “prospect” peut être découpé en plusieurs tokens selon le modèle. Toute la phrase “Bonjour, comment allez-vous ?” devient alors une séquence de tokens qui sera traitée mathématiquement.

3.2. Les embeddings : transformer les mots en nombres

Les tokens sont ensuite convertis en embeddings, c’est-à-dire en vecteurs de nombres. Ces vecteurs capturent des propriétés sémantiques : deux mots qui apparaissent souvent dans des contextes proches auront des embeddings proches dans l’espace mathématique.

C’est grâce aux embeddings que le modèle “comprend” qu’un client est plus proche d’un acheteur que d’une chaise.

3.3. Comment un LLM génère une réponse ?

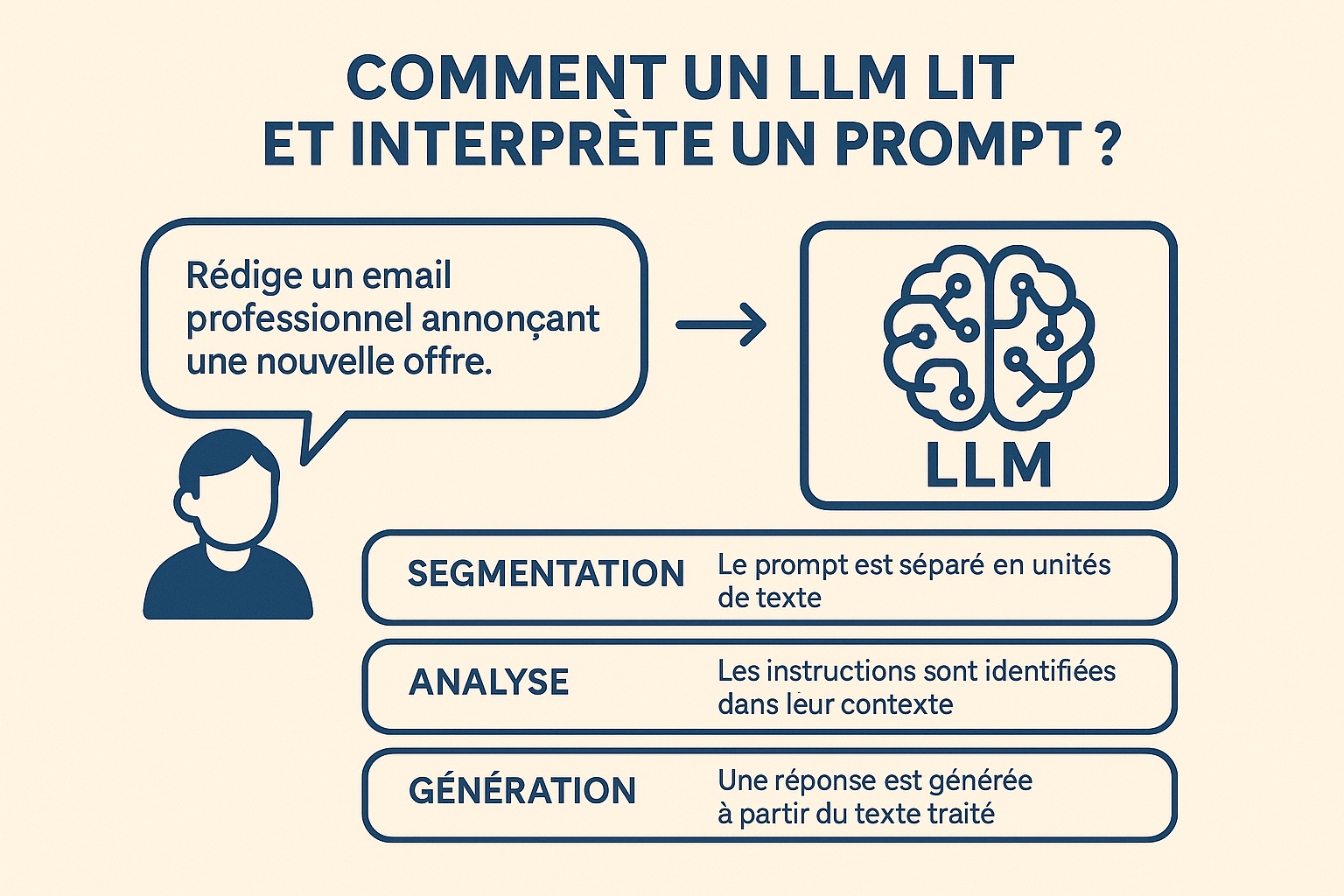

Lorsqu’un utilisateur envoie un prompt, le LLM suit, simplifié, les étapes suivantes :

- Le texte du prompt est converti en tokens.

- Les tokens sont transformés en embeddings.

- Le modèle analyse cette séquence et calcule la probabilité de chaque prochain token possible.

- Il choisit le token le plus probable (ou un token parmi les plus probables, selon certains paramètres).

- Il répète ce processus token par token jusqu’à construire une réponse complète.

Le LLM ne “réfléchit” pas comme un humain, il prédit la suite la plus plausible à partir de ce qu’il a appris pendant son entraînement.

💡 Pour les étudiants Mastère : La façon dont le modèle choisit le prochain token peut être contrôlée via deux paramètres clés :

- La température (de 0 à 2) : contrôle le niveau de créativité. Une température basse (0.2) rend les réponses plus prévisibles et factuelles, idéale pour des analyses techniques ou des résumés précis. Une température élevée (1.5-2) augmente l’originalité et la variété, utile pour du brainstorming créatif ou de la génération d’idées marketing.

- Le top-p (de 0 à 1) : détermine la diversité des tokens considérés. Un top-p de 0.1 force le modèle à choisir uniquement parmi les 10% de tokens les plus probables (réponses très cohérentes), tandis qu’un top-p de 0.9 élargit les possibilités (réponses plus variées et créatives).

Ces paramètres sont accessibles dans les versions API des LLM et permettent d’adapter finement le comportement du modèle selon l’usage : rigueur analytique vs. exploration créative.

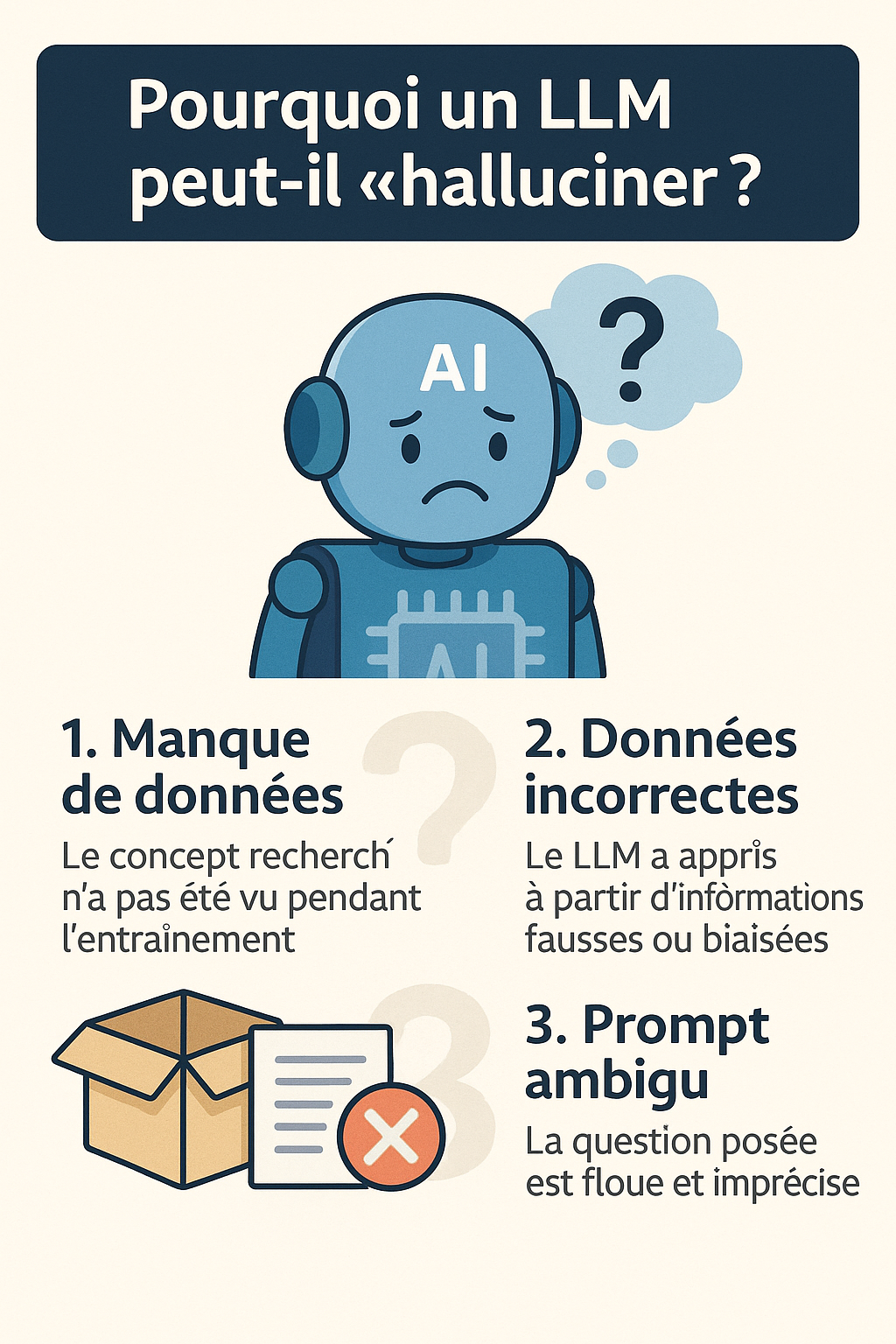

3.4. Pourquoi un LLM peut-il “halluciner” ?

On parle d’hallucination lorsqu’un LLM génère une réponse qui paraît crédible, mais qui est en réalité fausse ou inventée. Cela se produit parce que le modèle optimise la cohérence linguistique, pas la vérité factuelle.

- Il peut inventer une statistique ou une date.

- Il peut attribuer une citation à la mauvaise personne.

- Il peut décrire un événement qui n’a jamais eu lieu, mais d’une façon convaincante.

C’est une limite importante à garder en tête : les informations critiques doivent être vérifiées, et pour les usages professionnels sensibles, il est préférable de connecter le LLM à des sources de données fiables (via le RAG par exemple).

4. Les modèles génératifs : produire du texte, des images, des vidéos

Un modèle génératif ne se contente pas de classer ou de prédire une valeur. Il est capable de créer du contenu nouveau : du texte, des images, du son, de la vidéo, etc. Les LLM génèrent du texte, tandis que des modèles comme DALL·E ou Midjourney génèrent des images.

L’IA générative apprend à partir d’exemples : elle ne copie pas mot à mot, mais elle capture des styles, des structures, des tournures et des logiques, puis les réutilise pour produire un contenu qui semble naturel.

Exemples d’usages concrets en marketing:

- Rédiger un email de relance commerciale adapté au ton d’une entreprise.

- Produire un script de vidéo pour présenter une offre commerciale.

- Générer des idées de posts pour les réseaux sociaux.

- Proposer des arguments de réponse face à des objections fréquentes.

5. Comment un LLM lit et interprète un prompt ?

Le prompt est la façon dont vous “parlez” à l’IA. La qualité du prompt détermine directement la qualité de la réponse. Un prompt flou produit une réponse floue ; un prompt précis, contextualisé et structuré produit une réponse beaucoup plus pertinente.

5.1. Les éléments que le modèle cherche dans un prompt

- L’intention : que veut l’utilisateur ? (résumé, idées, plan, analyse, script, etc.).

- Le rôle : le modèle doit-il répondre comme un professeur, un expert, un commercial, un recruteur ?

- Le contexte : secteur, type de client, niveau des étudiants, objectif de la séquence.

- Les contraintes : longueur, ton, style, structure.

- Le format : texte continu, bullet points, tableau, plan en parties, script…

Plus ces éléments sont explicites dans le prompt, plus la réponse sera alignée avec vos attentes.

5.2. Exemples de prompt flou vs prompt précis

Prompt flou : « Fais-moi un mail. »

Le modèle ne sait ni le destinataire, ni l’objectif, ni le ton, ni la longueur.

Prompt précis : « Rédige un email de relance commerciale à destination d’un prospect B2B qui n’a pas répondu depuis 10 jours à une proposition. Ton professionnel mais chaleureux. Objectif : obtenir un rendez-vous téléphonique de 30 minutes. Longueur : 7 à 10 lignes. »

Dans le second cas, le modèle dispose de toutes les informations pour générer un email directement exploitable dans un contexte professionnel.

Prompt flou :

« Fais un mail pour relancer un client. »

Prompt précis (version mastère marketing IA) :

« Rédige un email de nurturing destiné à un lead “tiède” dans le secteur B2B SaaS.

Objectif : faire progresser le lead dans le funnel sans être trop commercial.

Contexte : le prospect a téléchargé un livre blanc il y a 10 jours mais n’a pas demandé de démo.

Ton : professionnel, informatif et orienté valeur.

Format : 10–12 lignes, avec 1 question stratégique en conclusion. »

Prompt flou :

« Analyse ce tableau. »

Prompt précis :

« Tu es un data analyst spécialisé en marketing digital.

Analyse ce tableau de données de campagnes Meta Ads (colonnes : CPM, CPC, CTR, ROAS, Spend).

Tâche : détecter les campagnes sous-performantes, expliquer les causes probables, proposer trois optimisations actionnables liées à l’audience, au format créatif et à l’enchère.

Format : plan en 3 parties + bullet points.

Niveau attendu : mastère marketing. »

Prompt flou :

« Fais une analyse de concurrents. »

Prompt précis :

« Réalise une analyse concurrentielle pour une startup de food delivery premium.

Inclure pour chaque concurrent : positionnement, proposition de valeur, pricing, UX site/app, stratégie SEO, stratégie social media, avantage compétitif détectable.

Objectif : identifier 5 opportunités différenciantes exploitables dans un pitch deck.

Format : tableau comparatif + 5 insights stratégiques.

Niveau exigé : mastère marketing / IA. »

6. Le Prompt Engineering : l’art de parler à l’IA

Le Prompt Engineering est la discipline qui consiste à concevoir des prompts efficaces pour obtenir le meilleur de l’IA. C’est une compétence clé, car un même outil peut être très peu utile ou extrêmement puissant selon la manière dont on lui parle.

Pour un étudiant en Mastère, maîtriser le Prompt Engineering permet :

- d’augmenter sa productivité dans les travaux écrits ;

- d’améliorer la qualité de ses analyses et de ses argumentaires ;

- de préparer plus rapidement des supports (emails, scripts, posts, présentations) ;

- de se différencier sur le marché du travail en sachant piloter l’IA plutôt que la subir.

7. Les grandes techniques de prompting

Les grandes techniques de prompting regroupent les méthodes les plus efficaces pour guider une IA et obtenir des réponses précises, structurées et adaptées à un contexte donné. Chaque technique agit comme un « levier » différent : certaines aident l’IA à raisonner (Chain-of-Thought), d’autres permettent de contrôler le style ou le comportement (Persona), tandis que d’autres encore structurent la créativité du modèle (Directional Stimulus Prompting). Comprendre et maîtriser ces approches permet de transformer une simple requête en un véritable pilotage de l’IA, capable de produire des contenus professionnels, cohérents et directement exploitables dans des études, des projets ou des missions en entreprise.

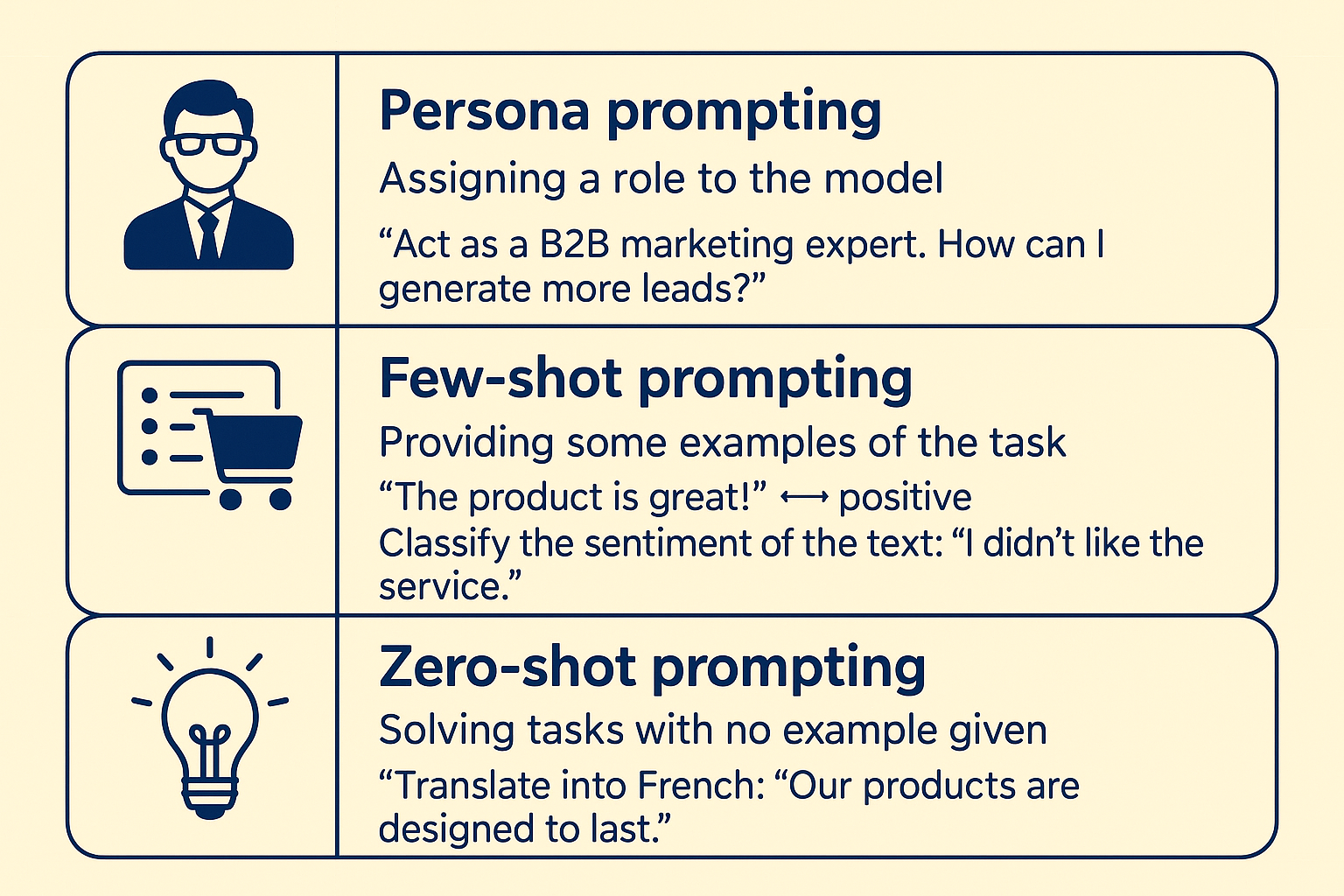

7.1. Zero-shot prompting

En zero-shot prompting, on se contente de formuler la tâche sans fournir d’exemple. Le modèle s’appuie uniquement sur sa connaissance générale.

Exemples :

- « Explique le concept de valeur perçue en marketing. »

- « Résume ce texte en 5 points clés. »

- « Liste les étapes d’un entretien de vente structuré. »

Simple et rapide, mais parfois insuffisant lorsque le style, le ton ou le format attendu sont très spécifiques.

7.2. Few-shot prompting

En few-shot prompting, on fournit au modèle quelques exemples avant de lui demander de produire une nouvelle réponse “dans le même style”.

Exemple : « Exemple 1 : [message de relance n°1]. Exemple 2 : [message de relance n°2]. En t’inspirant de ces deux exemples, rédige un troisième message de relance pour un prospect dans le secteur de l’immobilier. »

Le modèle va s’aligner sur la structure, la longueur, le ton et la forme globale des exemples fournis.

7.3. Persona prompting

Le persona prompting consiste à demander au modèle d’adopter un rôle (persona) : professeur, expert, commercial, coach, recruteur…

Exemples :

- « Agis comme un professeur de marketing. Explique le concept de segmentation à un étudiant débutant. »

- « Agis comme un commercial senior B2B. Propose un argumentaire pour convaincre un client hésitant. »

- « Agis comme un coach d’oral. Aide-moi à structurer une présentation de projet de 10 minutes. »

Le persona influence le niveau de langage, la structure et le ton de la réponse.

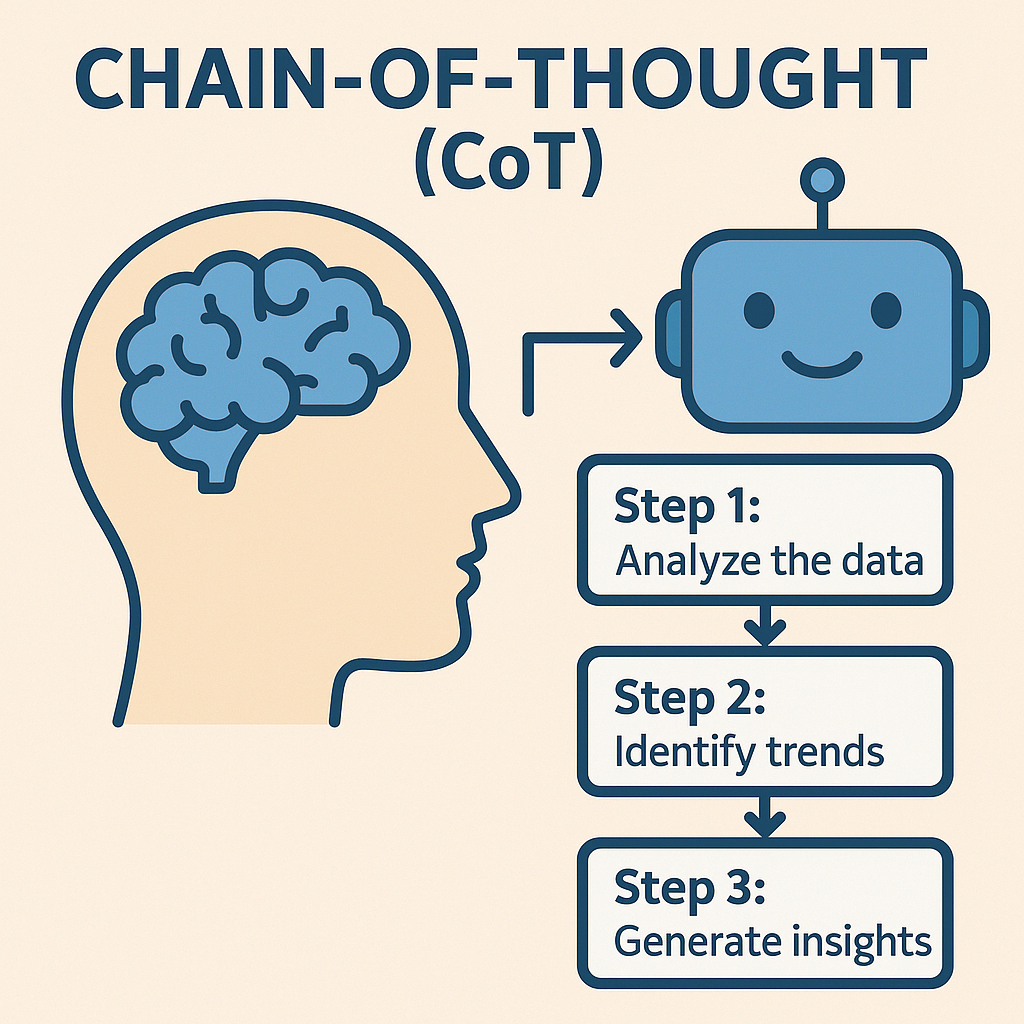

7.4. Chain-of-Thought (CoT)

La Chain-of-Thought (CoT) consiste à demander explicitement au modèle de raisonner étape par étape, plutôt que de donner uniquement la réponse finale.

Exemple 1: « Explique étape par étape comment analyser un fichier de ventes pour : 1) identifier les meilleurs clients, 2) repérer les produits les plus rentables, 3) proposer 3 actions pour augmenter le chiffre d’affaires. »

C’est particulièrement utile dans un contexte pédagogique, car cela expose le raisonnement et non seulement la conclusion.

Exemple 2 – Analyse d’une campagne Social Ads

« Raisonne étape par étape.

Tu es un expert en acquisition payante. Explique comment analyser les performances d’une campagne Meta Ads pour :

- identifier les annonces à couper,

- repérer les créas à scaler,

- proposer 3 optimisations concrètes sur le ciblage, les formats et le budget.

Détaille ton raisonnement avant de donner tes recommandations finales. »

Exemple 3 – Lancement d’un nouveau produit

« Explique étape par étape comment construire un plan de lancement pour un nouveau service d’abonnement de coaching en ligne :

- analyser la cible et la concurrence,

- choisir les canaux d’acquisition prioritaires,

- définir les indicateurs de performance (KPI) à suivre pendant les 3 premiers mois.

Présente ton raisonnement sous forme de liste numérotée, puis donne une synthèse finale. »

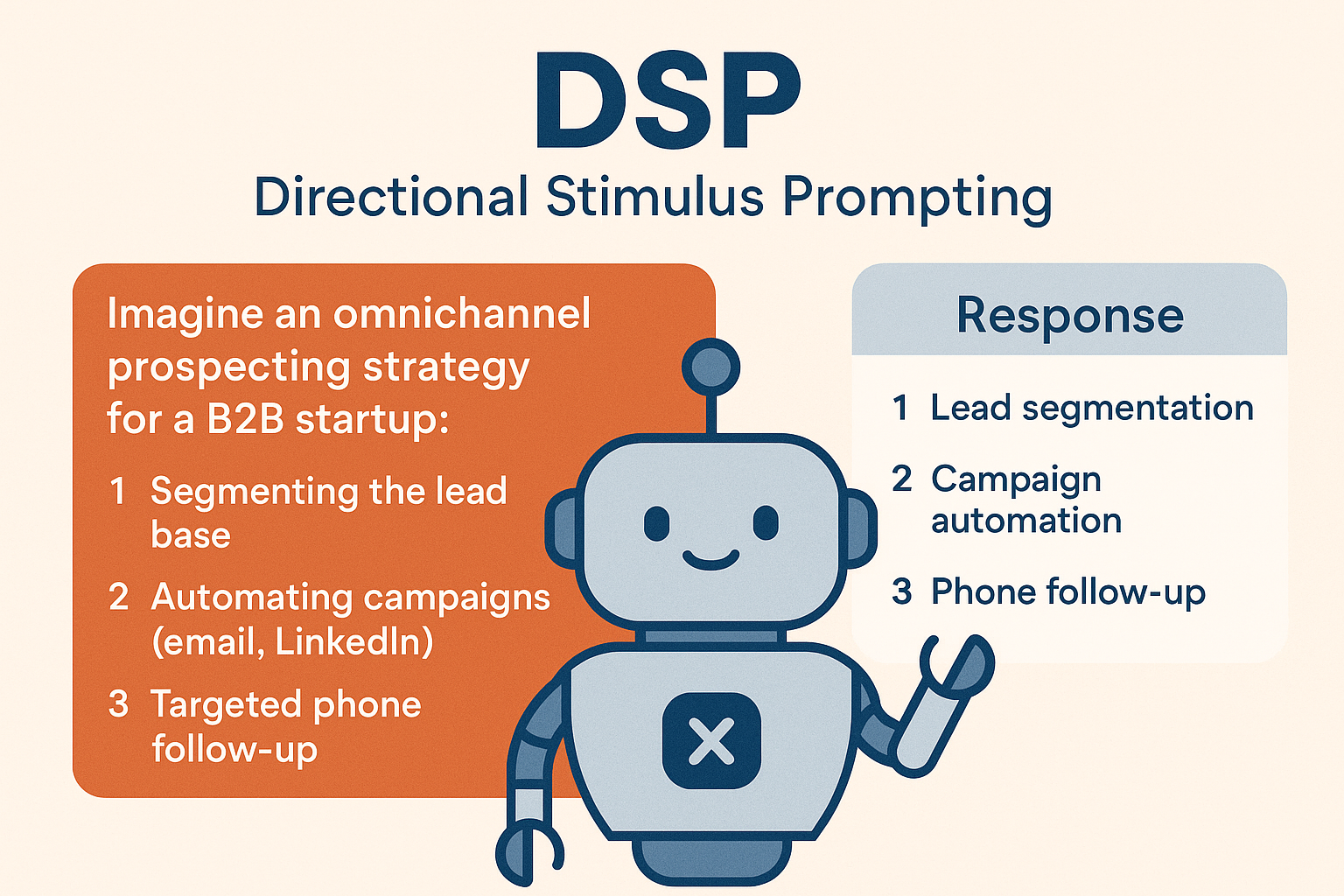

7.5. Directional Stimulus Prompting (DSP)

Le Directional Stimulus Prompting (DSP) consiste à guider la créativité du modèle en lui donnant des axes précis de réflexion.

Exemple 1 : « Imagine une stratégie de prospection omnicanale pour une startup B2B. Concentre-toi sur : 1) la segmentation de la base de prospects, 2) l’automatisation des campagnes (email, LinkedIn), 3) la relance téléphonique ciblée. Présente ta réponse sous forme de plan en 3 parties. »

Le modèle va structurer sa réponse selon ces axes, ce qui rend le résultat plus exploitable qu’une réponse libre et non cadrée.

Exemple 2 – Calendrier éditorial

« Imagine un calendrier éditorial LinkedIn pour un étudiant en mastère marketing spécialisé en IA qui souhaite développer sa marque personnelle.

Concentre-toi sur :

- des posts pédagogiques (vulgarisation de concepts IA / data),

- des posts “coulisses” sur ses projets d’étude,

- des posts orientés carrière (stage, alternance, networking).

Propose un planning de 8 posts sur 1 mois, avec pour chaque post : angle, format (carrousel, texte, vidéo), et objectif. »

Exemple 3 – Refonte d’un parcours emailing

« Propose une refonte d’un scénario d’emailing automatisé pour une marque de cosmétiques en ligne.

Concentre-toi sur :

- l’email de bienvenue,

- la série d’éducation produit,

- la relance après abandon de panier.

Pour chaque séquence, décris : objectif, nombre d’emails, message clé, call-to-action principal. Présente la réponse sous forme de tableau. »

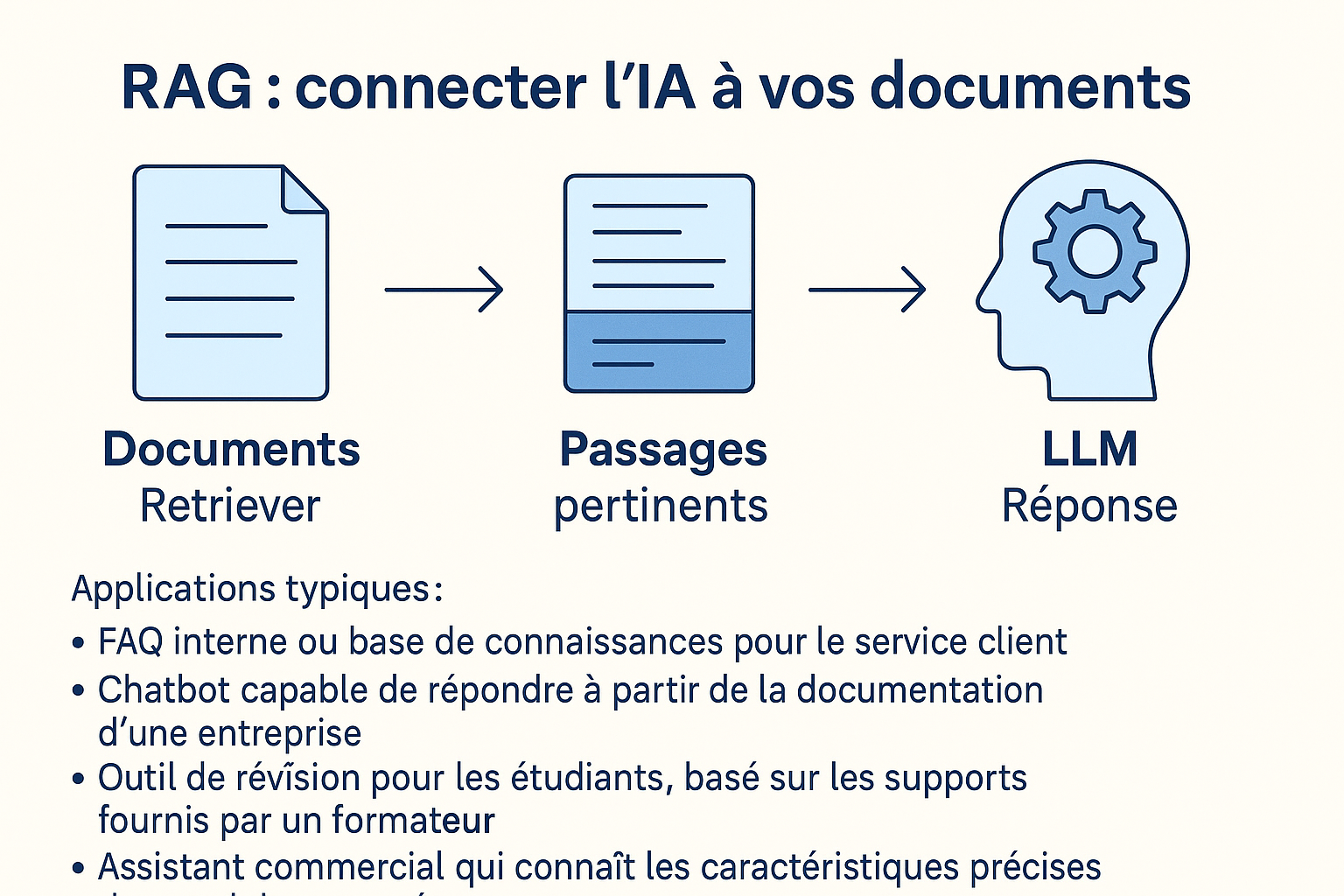

8. RAG (Retrieval-Augmented Generation) : connecter l’IA à vos documents

Un LLM généraliste (ChatGPT, Mistral, Gemini…) ne connaît pas vos documents internes :

- cours,

- supports PDF,

- process internes,

- CGV,

- fiches produits,

- documentation commerciale,

- procédures RH, SAV, qualité…

Il se base uniquement sur son entraînement général, ce qui provoque :

- des réponses inexactes,

- des approximations,

- des “hallucinations”,

- des oublis du vocabulaire propre à l’entreprise.

Le RAG résout ce problème.

🔍 RAG : Comment ça fonctionne ?

Le RAG combine deux modules distincts :

1. Le Retriever

Il « fouille » dans une base documentaire (PDF, FAQ, fiches produits, supports de cours, CRM…)

et sélectionne uniquement les passages pertinents pour répondre à la question.

Il agit comme un moteur de recherche intelligent interne.

2. Le LLM

À partir de ces passages, il génère une réponse en :

- reformulant,

- expliquant,

- synthétisant,

- contextualisant,

- éliminant les informations inutiles.

Le LLM ne “devine” plus :

il s’appuie sur vos documents réels.

C’est la différence entre :

❌ “Et si l’IA racontait n’importe quoi…”

et

✅ “L’IA répond exactement comme un expert de votre entreprise.”

🎯 Pourquoi le RAG est indispensable dans un contexte professionnel ?

Parce qu’un LLM seul :

- n’a pas accès à vos données internes,

- n’a pas la dernière version de vos process,

- ne connaît pas votre offre produit réelle,

- ne sait pas ce qu’un formateur ou un manager a expliqué en cours,

- ne peut pas faire référence à vos PDF, documents pédagogiques ou supports internes.

Avec le RAG, vous créez un assistant personnalisé, calé sur votre réalité.

📌 Applications typiques du RAG

1. Service client (FAQ intelligente)

Un agent peut poser une question :

« Comment gérer un retour produit hors délai ? »

L’IA répond en s’appuyant sur :

- les CGV,

- les procédures internes,

- les scripts SAV.

2. Chatbot interne pour les collaborateurs

L’IA devient un point d’entrée :

- pour les nouveaux employés,

- pour retrouver une procédure,

- pour obtenir un processus RH ou qualité,

- pour comprendre un workflow interne.

3. Révision intelligente pour les étudiants

Pour un mastère marketing :

- l’IA peut répondre à partir des supports du formateur,

- reformuler un chapitre,

- générer des quiz basés sur le cours,

- créer des flashcards personnalisées.

4. Assistant commercial ultra-précis

L’IA peut générer :

- scripts d’appel,

- argumentaires,

- réponses aux objections,

- comparatifs produits,

- email de relance,

en s’appuyant directement sur : - les fiches produits,

- les tarifs,

- les brochures,

- les cas clients.

C’est l’équivalent d’un assistant avant-vente connecté au cerveau de l’entreprise.

5. Analyse documentaire automatisée

Exemples :

- résumer un PDF de 100 pages en 10 points clés,

- identifier les passages contenant un terme ou un concept,

- extraire les définitions importantes,

- réécrire un document dans un autre style.

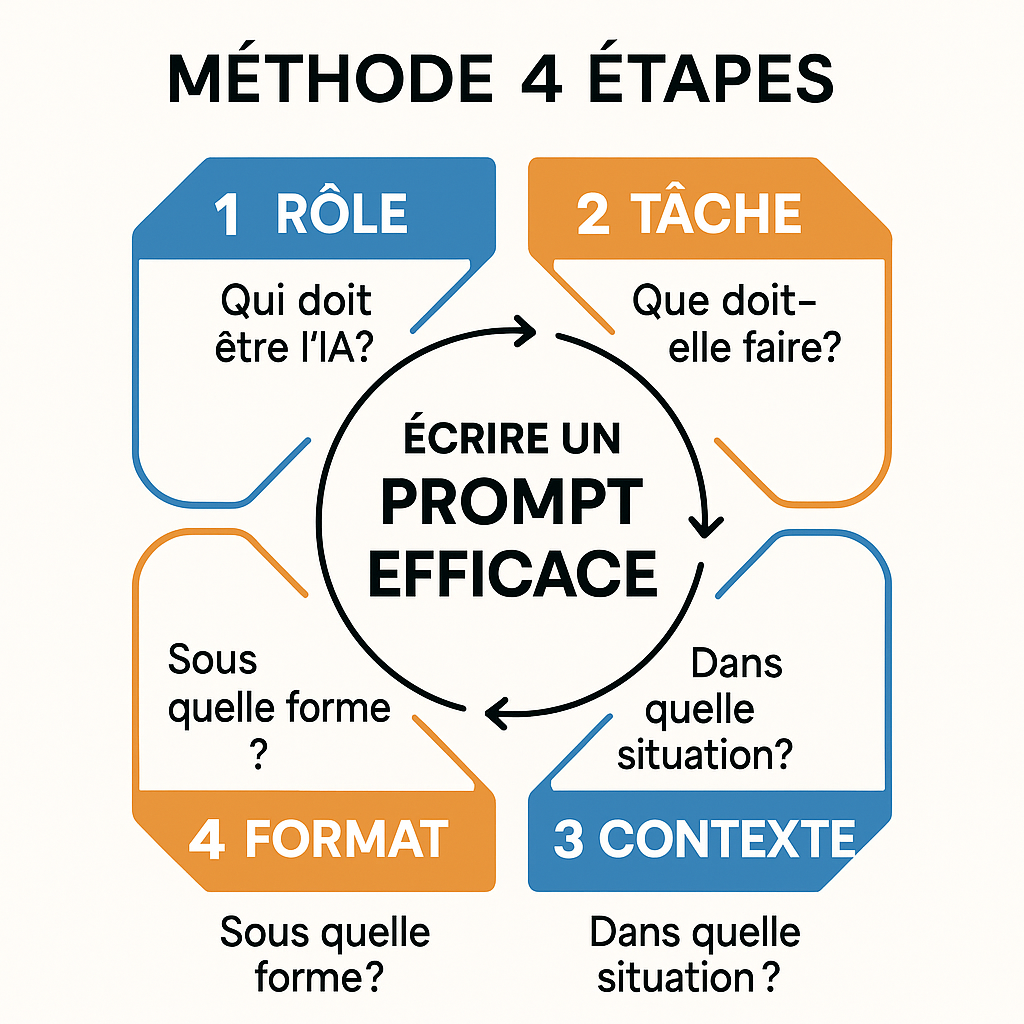

9. Comment rédiger un prompt efficace ? (Méthode en 4 étapes)

Un bon prompt n’est pas une phrase jetée à l’IA.

C’est une instruction structurée, précise et exploitable, construite selon 4 piliers simples mais essentiels.

Imagine une boussole du prompt :

Rôle → Tâche → Contexte → Format.

Chaque pilier ajoute une couche de précision qui améliore la qualité de la réponse.

Plus tu les formules clairement, plus le modèle devient performant… pour toi.

Étape 1 — Rôle : Qui doit être l’IA ?

L’IA ne sait rien de ton besoin tant que tu ne lui dis pas qui elle doit incarner.

Le rôle oriente immédiatement le ton, la structure, le niveau d’expertise.

Exemples de rôles utiles pour un étudiant en mastère marketing :

- Expert en marketing digital

- Consultant en data marketing

- Professeur en négociation commerciale

- Analyste CRM

- Growth marketer

- Chef de produit

- Coach en pitch deck

- Rédacteur web SEO

- Social media strategist

Le rôle donne une identité professionnelle au modèle.

Étape 2 — Tâche : Que doit exactement produire l’IA ?

Il faut préciser l’action demandée pour éviter les réponses génériques.

Décris la tâche de manière opérationnelle.

Exemples de tâches :

- « Analyser les performances d’une campagne Google Ads »

- « Rédiger un email de nurturing »

- « Construire un plan marketing en 3 étapes »

- « Résumer un article en 5 points clés »

- « Générer 10 idées de posts LinkedIn »

- « Expliquer un concept comme à un débutant »

Sans tâche claire → réponse vague.

Avec tâche explicite → réponse utile.

Étape 3 — Contexte : Dans quelle situation précise ?

Le contexte est ce qui change une réponse acceptable en une réponse vraiment pertinente.

C’est ce que les débutants oublient le plus souvent.

Types d’informations contextuelles utiles :

- secteur : retail, SaaS, immobilier, luxe…

- cible : jeunes actifs, dirigeants de PME, étudiants, parents…

- niveau : débutant, intermédiaire, avancé

- contrainte : budget, durée, volume, ton, canal

- objectif final : convaincre, expliquer, vendre, synthétiser…

Exemples marketing :

- « Campagne B2C destinée à des femmes 25–35 ans »

- « Budget de communication limité à 8 000 € »

- « Contexte : campagne de relance post-abandon de panier »

- « Cible : prospects tièdes ayant interagi avec un webinar »

L’IA devient immédiatement plus pertinente.

Étape 4 — Format : Sous quelle forme veux-tu la réponse ?

L’IA sait tout faire… mais seulement si tu le dis.

La forme finale doit être imposée, jamais implicite.

Formats utiles en mastère marketing :

- Liste à puces

- Tableau comparatif

- Plan structuré

- Email professionnel

- Post LinkedIn

- Script vidéo

- Synthèse en 5 points

- SEO-friendly

- Grappe de mots-clés

- Fiche pédagogique

Indique aussi la longueur : 5 lignes, 10 bullet points, 3 paragraphes, etc.

🔧 La méthode complète en un seul regard

Rôle → Tâche → Contexte → Format

= prompt clair, structuré, professionnel.

Exemple de prompt efficace

« Tu es un formateur expert en négociation commerciale.

Ta tâche est de créer un cas pratique complet pour entraîner des étudiants en mastère marketing à la vente B2B.

Contexte : vente d’un logiciel CRM à une PME de 35 employés, décideur : directeur commercial, budget limité, objection principale : “nous avons déjà un outil interne”.

Format :

- Fiche de contexte (10 lignes maximum)

- Rôle du vendeur et rôle du client

- 5 objectifs pédagogiques

- Liste de 8 objections possibles + réponses attendues

- Grille d’évaluation simplifiée »

Pourquoi cette structure fonctionne si bien ?

Parce qu’elle force l’IA à :

- adopter le bon niveau d’expertise (rôle),

- comprendre précisément la mission (tâche),

- s’ancrer dans une situation réaliste (contexte),

- produire un livrable directement exploitable (format).

C’est la différence entre :

❌ « Une réponse correcte » et ✅ « Une réponse professionnelle que tu peux utiliser dans un cours, un projet, un stage ou une mission rémunérée ».

10. Exemples avancés orientés Marketing

10.1. Relance commerciale

Prompt exemple : « Tu es un commercial senior B2B. Ta mission est de rédiger un email de relance à un prospect qui n’a pas répondu depuis 10 jours à une proposition. Contexte : solution SaaS de gestion de projet pour PME. Objectif : obtenir un rendez-vous de 30 minutes pour répondre à ses questions. Format : email de 8 à 10 lignes, ton professionnel et chaleureux, avec un appel à l’action clair. »

10.2. Analyse d’un fichier CRM

Prompt exemple : « Raisonne étape par étape. Tu es un analyste commercial. On t’a fourni un fichier CRM contenant : nom du prospect, secteur, taille de l’entreprise, nombre de contacts, statut (nouveau, relancé, perdu, client), montant potentiel. Explique : 1) comment segmenter les prospects par priorité, 2) comment identifier les signaux de churn, 3) quelles actions concrètes recommander à l’équipe commerciale pour les 30 prochains jours. »

10.3. Préparation d’un oral

Prompt exemple : « Tu es un coach d’oral pour des étudiants Bachelor. Aide-moi à construire un plan de présentation de 10 minutes pour un projet de développement commercial. Contexte : jury composé de professionnels, objectif : convaincre de la pertinence de la stratégie proposée. Format : plan détaillé avec introduction, 3 grandes parties, conclusion, et pour chaque partie 3 bullet points. »

10.4. Analyse de campagne réseaux sociaux (niveau Bachelor)

Prompt exemple : « Tu es un social media manager. Analyse cette campagne Instagram pour une marque de cosmétiques bio. Contexte : 12 publications en 1 mois, budget boost de 500€, objectif : augmenter l’engagement et générer du trafic vers le site e-commerce. Tâche : identifie les 3 types de posts qui ont le mieux fonctionné (likes, commentaires, partages), explique pourquoi, et propose 3 recommandations concrètes pour le mois prochain. Format : tableau comparatif + 3 recommandations détaillées. »

10.5. Création de personas clients (niveau Bachelor)

Prompt exemple : « Agis comme un consultant en stratégie marketing. Aide-moi à créer 3 personas clients pour une startup de livraison de repas végétariens en milieu urbain. Pour chaque persona, inclus : nom fictif, âge, profession, motivations d’achat, freins potentiels, canaux de communication préférés, comportement d’achat type. Contexte : cible urbaine 25-45 ans, budget moyen par commande 15-25€. Format : fiche persona détaillée pour chacun (10 lignes maximum par persona). »

11. Bonnes pratiques, erreurs à éviter et optimisation des prompts

11.1. Bonnes pratiques

- Être explicite sur l’objectif et le contexte.

- Donner des contraintes de format (longueur, structure, ton).

- Utiliser des personas pour adapter le niveau de langage.

- Demander une Chain-of-Thought pour les sujets complexes ou pédagogiques.

- Tester plusieurs variantes de prompts et comparer les résultats.

11.2. Erreurs fréquentes

- Prompts trop courts et trop vagues.

- Objectifs multiples non hiérarchisés dans un même prompt.

- Absence de contexte (secteur, cible, niveau, contraintes réelles).

- Ne pas préciser le format attendu et devoir tout retravailler à la main.

- Ne pas relire ni vérifier les informations importantes fournies par le modèle.

11.3. Optimiser progressivement

Le Prompt Engineering est un processus itératif. On commence avec une première version, puis on améliore :

- si la réponse est trop générale, ajouter du contexte ;

- si elle est trop longue, fixer une limite de mots ou de lignes ;

- si le ton ne convient pas, préciser le style attendu (formel, dynamique, pédagogique, familier…) ;

- si la structure ne convient pas, imposer un format (liste, plan, tableau, script…).

Conclusion : de l’utilisateur d’IA au pilote d’IA

L’IA générative transforme la manière de travailler en négociation, en vente, en relation client et en marketing. La différence ne se fera pas entre ceux qui “ont accès à ChatGPT” et les autres, mais entre ceux qui savent piloter l’IA et ceux qui se contentent de l’utiliser de façon superficielle.

En comprenant le Machine Learning, le Deep Learning, les LLM et le Prompt Engineering, vous développez une compétence clé : la capacité à dialoguer efficacement avec des systèmes d’intelligence artificielle, à les orienter et à les intégrer dans vos pratiques professionnelles.

Autrement dit, vous ne vous contentez plus d’être simple utilisateur d’IA. Vous devenez progressivement pilote d’IA.

Dans le prochain article, nous verrons comment utiliser l’IA de manière éthique et efficace dans vos études et vos projets professionnels, sans tomber dans la triche facilement détectable, mais en développant une véritable compétence de collaboration homme-machine qui fera toute la différence sur le marché du travail.

Bonus : Exercice de mise en pratique : maîtriser le Prompt Engineering

Cet exercice vous permet d’appliquer les principes vus en cours : Zero-shot, Persona, Few-shot et Chain-of-Thought (CoT). Vous apprendrez à transformer un prompt basique en un prompt exploitable et professionnel.

Objectifs pédagogiques

- Savoir formuler un prompt clair, contextualisé et structuré.

- Comprendre l’impact d’un persona sur la qualité d’une réponse IA.

- Savoir utiliser des exemples (few-shot) pour contrôler le style.

- Apprendre à demander un raisonnement étape par étape (CoT).

Consigne générale

Pour chaque partie, rédigez un prompt complet et testez-le dans votre IA préférée (ChatGPT, Claude, Gemini, Mistral…). Comparez les résultats entre les différentes approches.

1. Zero-shot : formuler une tâche simple

Énoncé : Vous devez demander à une IA de rédiger un message de relance commerciale court destiné à un prospect B2B qui n’a pas répondu depuis 5 jours.

Tâche :

Rédigez un prompt Zero-shot (sans exemples, sans persona). Il doit faire 1 seule phrase.

Exemple de départ à améliorer : « Fais-moi une relance pour un prospect. »

2. Persona prompting : améliorer la qualité

Énoncé : Vous devez maintenant améliorer la qualité du message en demandant à l’IA d’adopter un rôle spécifique.

Tâche :

Rédigez un prompt dans lequel l’IA doit jouer un commercial senior B2B.

Ajoutez :

- le ton souhaité,

- la longueur,

- l’objectif (réobtenir un échange).

3. Few-shot + Chain-of-Thought : contrôler le style et le raisonnement

Énoncé : Vous devez cette fois produire un prompt très précis permettant d’obtenir un message de relance structuré et pédagogique, adapté à un étudiant qui apprend la vente.

Tâche :

Incluez :

- 2 exemples de messages de relance (même courts),

- un persona (formateur en négociation),

- une demande de raisonnement étape par étape (CoT),

- un format clair avec titre + message final.

Vous devez obtenir un prompt d’au moins 8 lignes.

Correction (propositions de réponses)

Correction — Partie 1 (Zero-shot)

Prompt possible :

« Rédige un message court pour relancer un prospect B2B n’ayant pas répondu depuis 5 jours. »

Correction — Partie 2 (Persona prompting)

Prompt possible :

« Agis comme un commercial senior B2B. Rédige un message de relance de 6 à 8 lignes destiné à un prospect qui n’a pas répondu depuis 5 jours. Ton professionnel et chaleureux. Objectif : obtenir un appel téléphonique de 20 à 30 minutes. »

Correction — Partie 3 (Few-shot + CoT)

Prompt complet proposé :

« Tu es un formateur expert en négociation commerciale. Voici deux exemples de messages de relance :

Exemple 1 : “Bonjour, je me permets de revenir vers vous suite à notre dernier échange. Seriez-vous disponible pour en discuter cette semaine ?”

Exemple 2 : “Je reprends contact pour savoir si vous avez eu le temps de réfléchir à notre proposition. Un rapide échange pourrait vous aider à avancer.”

En t’inspirant de ces exemples, rédige un troisième message adapté à un étudiant en Bachelor NDRC. Utilise un ton clair et pédagogique.

Raisonne étape par étape pour expliquer : 1) ce qui doit apparaître dans une bonne relance, 2) comment structurer le message, 3) pourquoi ce format est efficace.

Présente la réponse finale au format suivant :

1) Raisonnement détaillé

2) Message final prêt à l’emploi »

Grille d’auto-évaluation (à compléter par l’étudiant)

- Objectif clair : Mon prompt décrit-il précisément ce que j’attends ?

- Persona adapté : Ai-je choisi un rôle pertinent pour la tâche ?

- Contexte fourni : Le modèle a-t-il tous les éléments nécessaires ?

- Contraintes explicites : Ai-je indiqué la longueur, le ton, le format ?

- Structure : Mon prompt est-il organisé et lisible ?

- Exemples : Ai-je utilisé des exemples lorsque nécessaire ?

- Raisonnement : Ai-je demandé une Chain-of-Thought pour les tâches complexes ?

Score recommandé :

0–3 = À retravailler

4–6 = Correct, mais peut mieux faire

7 = Très bon prompt